Lecture

Это продолжение увлекательной статьи про обработка данных в психологии.

...

example, taken from two different groups of subjects) or dependent (that is, reflecting the results of the same group of subjects). before and after exposure or after two different exposures).

One or another conclusion with a certain probability may be erroneous, and this probability is the smaller, the more data is available to substantiate this conclusion. Thus, the more results are obtained, the more can one judge from the differences between the two samples what is really the case in the population from which the samples were taken.

However, the commonly used samples are relatively small, and in these cases the probability of error can be significant. In the humanities, it is generally accepted that the difference between two samples reflects the real difference between the respective populations only if the probability of error for this statement does not exceed 5%, i.e. There are only 5 chances out of 100 to err in making such a statement. This is the so-called confidence level (reliability level, confidence level) differences. If this level is not exceeded, then it can be considered probable that the difference we have identified really reflects the state of affairs in the population (hence another name for this criterion is the probability threshold ).

For each statistical method, this level can be obtained from the tables of the distribution of critical values of the corresponding criteria (t, χ2 , etc.); these tables give figures for levels of 5% (0.05), 1% (0.01), or even higher. If the criterion value for a given number of degrees of freedom (see Appendix turns out to be below a critical level corresponding to a 5% probability threshold, then the null hypothesis cannot be considered disproved, and this means that the revealed difference is unreliable.

This is a parametric method used to test the hypotheses about the reliability of the difference in averages when analyzing quantitative data on populations with a normal distribution and with the same variant. Unfortunately, the Student’s method is too often used for small samples, without first making sure that the data in the respective populations obey the law of normal distribution (for example, the results of performing too easy a task that all subjects coped with, or, conversely, too difficult a task). do not give a normal distribution).

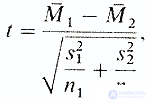

Student's trick is different for independent and dependent samples. Independent samples are obtained by examining two different groups of subjects (in our experiment, these are control and experimental groups). In the case of independent samples, the formula

where m1 is average of the first sample; M2 is the average of the second sample; s1 is the standard deviation for the first sample; s2 is the standard deviation for the second sample; nl and n2 are the number of elements in the first and second samples.

Now it remains only to find in the table of t values (see Appendix) the value corresponding to n-2 degrees of freedom, where n is the total number of subjects in both samples, and compare this value with the result of the calculation by the formula.

If our result is greater than the value for the confidence level of 0.05 (5% probability) found in the table, then we can discard the null hypothesis (H0) and accept the alternative hypothesis (H1) ie consider the difference averages reliable.

If, on the contrary, the result obtained in the calculation is less than the tabular one (for n-2 degrees of freedom), then the null hypothesis cannot be rejected and, therefore, the difference of averages is unreliable.

In our experiment, using the Student’s method for independent samples, it would be possible, for example, to check whether there is a significant difference between the background levels (values obtained prior to exposure to the independent variable) for the two groups. In this case, we get:

Having checked the table of values of t , we can come to the following conclusions: the value of t = 0.53 obtained by us is less than that which corresponds to a confidence level of 0.05 for 26 degrees of freedom (h) = 28); therefore, the level of probability for such a t will be above 0.05 and the null hypothesis cannot be discarded; thus, the difference between two samples is unreliable, that is, they may well belong to the same population.

Abbreviated this output is written as follows:

t = 0.53; h = 28; p> 0.05; unreliable.

As already mentioned, since the sample size in this case is small, and the results of the experimental group after exposure do not correspond to the normal distribution, it is better to use a non-parametric method, for example, the Mann-Whitney U test.

However, the most useful t- test will be for us when testing the hypothesis about the reliability of the average difference between the results of the experimental and control groups after exposure. Try to find the values for these samples and draw the appropriate conclusions.

In order to minimize errors, the tables of critical values of statistical criteria in the total amount of data do not take into account those that can be deduced by the deduction method. The remaining data are the so-called number of degrees of freedom , that is, the number of data from the sample, the values of which may be random.

So, if the sum of the three data is equal to 8, then the first two of them can take any values, but if they are defined, then the third value becomes automatically known. If, for example, the value of the first given is 3 and the second is -1, then the third can only be equal to 4. Thus, in such a sample there are only two degrees of freedom. In the general case, for sampling in n data, there is n -1 degree of freedom.

If we have two independent samples, then the number of degrees of freedom for the first one is n1 -1, and for the second one - n2 -1. And since the determination of the reliability of the difference between them is based on the analysis of each sample, the number of degrees of freedom, according to which it will be necessary to find the criterion t in the table, will be ( n1 + n2) -2.

If we are talking about two dependent samples, then the calculation is based on calculating the sum of the differences obtained for each pair of results (that is, for example, the differences between the results before and after exposure to the same subject). Since one (any) of these differences can be calculated, knowing the remaining differences and their sum, the number of degrees of freedom for determining the criterion t will be equal to n- 1.

Dependent samples include, for example, the results of the same group of subjects before and after exposure to an independent variable. In our case, using statistical methods for dependent samples, we can test the hypothesis about the reliability of the difference between the background level and the level after exposure separately for the experimental and control groups.

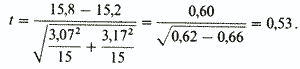

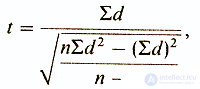

The following formula is used to determine the validity of the difference in the means for dependent samples:

where d is the difference between the results in each pair; S d - the sum of these partial differences; S d 2 - the sum of the squares of the partial differences. The results obtained are compared with the table t , looking for values corresponding to n- 1 degrees of freedom; n is in this case the number of data pairs (see Appendix.

Before using the formula, for each group it is necessary to calculate the partial differences between the results in all pairs, the square of each of these differences, the sum of these differences and the sum of their squares.

It is necessary to perform the following operations:

Control group. Comparison of results for background and after exposure

| Test subjects | Background | After exposure | d | d 2 |

| D1 | nineteen | 21 | +2 | four |

| 2 | ten | eight | -2 | four |

| 3 | 12 | 13 | +1 | one |

| four | 13 | eleven | -2 | four |

| five | 17 | 20 | +3 | 9 |

| 6 | 14 | 12 | -2 | four |

| 7 | 17 | 15 | -2 | four |

| Y1 | 15 | 17 | +2 | four |

| 2 | 14 | 15 | +1 | one |

| 3 | 15 | 15 | - | - |

| four | 17 | 18 | +1 | one |

| five | 15 | sixteen | +1 | one |

| 6 | 18 | 15 | -3 | 9 |

| 7 | nineteen | nineteen | - | - |

| eight | 22 | 25 | +3 | 9 |

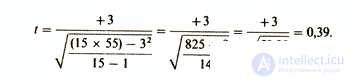

| S d = +3; S d 2 = 55 | ||||

The value t = 0.39 is lower than that required for a significance level of 0.05 with 14 degrees of freedom. In other words, the probability threshold for such t is above 0.05. Thus, the null hypothesis cannot be rejected, and the difference between samples is unreliable. In abbreviated form, this is written as follows:

t = 0.39; h = 14; p> 0.05; unreliable.

Now try applying the Student’s method for dependent samples yourself to both distributions of the experimental group, taking into account the fact that the calculation of the partial differences for the pairs yielded the following results:

S d = -59 and S d 2 = 349

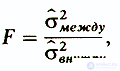

The Snedecor method is a parametric test used in cases where there are three or more samples. The essence of this method is to determine whether the spread of the averages for different samples relative to the total average for the entire set of data is significantly different from the spread of the data relative to the average within each sample . If all samples belong to the same population, the spread between them should be no more than the spread of the data within them.

In the Snedecor method, variance (variance) is used as an index of variation. Therefore, the analysis is reduced to comparing the variant of distributions between samples with the options within each sample, or:

t = .....; h = .....; p ..... (<, =,>?) 0.05; unreliable

where σ2 between - the variation of the average of each sample relative to the total average;

σ2internal - version of the data within each sample. If the difference between samples is not significant, then the result should be close to I. The greater the F compared to 1, the more significant the difference.

Thus, analysis of variance shows whether the samples belong to one population, but it cannot be used to distinguish those samples that differ from others. In order to determine those pairs of samples, the difference between which is reliable, one should, after analysis of variance, apply the Scheffe method. Since, however, this very Valuable method requires rather large calculations, and it is not applicable to our hypothetical experiment, we recommend the reader to get acquainted with it with a special manual on statistics.

To use the nonparametric χ2 method, it is not necessary to calculate the mean or standard deviation. Его преимущество состоит в том, что для применения его необходимо знать лишь зависимость распределения частот результатов от двух переменных; это позволяет выяснить, связаны они друг с другом или, наоборот, независимы. Таким образом, этот статистический метод используется для обработки качественных данных. Кроме того, с его помощью можно проверить, существует ли достоверное различие между числом людей, справляющихся или нет с заданиями какого-то интеллектуального теста, и числом этих же людей, получающих при обучении высокие или низкие оценки; между числом больных, получивших новое лекарство, и числом тех, кому это лекарство помогло; и, наконец, существует ли достоверная связь между возрастом людей и их успехом или неудачей в выполнении тестов на память и т. п. Во всех подобных случаях этот тест позволяет определить число испытуемых, удовлетворяющих одному и тому же критерию для каждой из переменных.

При обработке данных нашего гипотетического эксперимента с помощью метода Стьюдента мы убедились в том, что употребление марихуаны испытуемыми из опытной группы снизило у них эффективность выполнения задания по сравнению с контрольной группой. Однако к такому же выводу можно было бы прийти с помощью другого метода — χ2. Для этого метода нет ограничений, свойственных методу Стьюдента: он может применяться и в тех случаях, когда распределение не является нормальным, а выборки невелики.

При использовании метода χ2 достаточно сравнить число испытуемых в той и другой группе, у которых снизилась результативность, и подсчитать, сколько среди них было получивших и не получивших наркотик; после этого проверяют, есть ли связь между этими двумя переменными.

Из результатов нашего опыта, приведенных в Таблице 1, видно, что из 30 испытуемых, составляющих опытную и контрольную группы, у 18 результативность снизилась, а 13 из них получили марихуану. Теперь надо внести значение этих так называемых эмпирических частот (Э) в специальную таблицу:

| results | ||||

| Impairment | Без изменений или улучшение | Total | ||

| Conditions | После употребления наркотика | 13 | 2 | 15 |

| Без наркотика | five | ten | 15 | |

| Total | 18 | 12 | thirty | |

Далее надо сравнить эти данные с теоретическими частотами (Т) , которые были бы получены, если бы все различия были чисто случайными. Если учитывать только итоговые данные, согласно которым, с одной стороны, у 18 испытуемых результативность снизилась, а у 12 — повысилась, а с другой — 15 из всех испытуемых курили марихуану, а 15 — нет, то теоретические частоты будут следующими:

| results | ||||

| Impairment | Без изменений или улучшение | Total | ||

| Conditions | После употребления накортика | 18*15/30=9 | 12*15/30=6 | 15 |

| Без наркотика | 18*15/30=9 | 12*15/30=6 | 15 | |

| Total | 18 | 12 | thirty | |

Метод χ2 состоит в том, что оценивают, насколько сходны между собой распределения эмпирических и теоретических частот. Если разница между ними невелика, то можно полагать, что отклонения эмпирических частот от теоретических обусловлены случайностью. Если же, напротив, эти распределения будут достаточно разными, можно будет считать, что различия между ними значимы и существует связь между действием независимой переменной и распределением эмпирических частот.

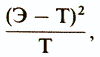

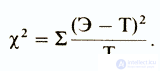

Для вычисления χ2 определяют разницу между каждой эмпирической и соответствующей теоретической частотой по формуле

а затем результаты, полученные по всех таких сравнениях, складывают:

В нашем случае все это можно представить следующим образом:

| Uh | T | Э-Т | (Э-Т)2 | (Э-Т)2/Т | |

| Наркотик, улучшение | 13 | 9 | +4 | sixteen | 1,77 |

| Наркотик, ухудшение | 2 | 6 | -four | sixteen | 2.66 |

| Без наркотика, ухудшение | five | 6 | -four | sixteen | 1,77 |

| Без наркотика, улучшение | ten | 6 | +4 | sixteen | 2.66 |

χ=S(Э-Т)2/Т= | 8,66 | ||||

Для расчета числа степеней свободы число строк в табл. 2 за вычетом единицы умножают на число столбцов за вычетом единицы. Таким образом, в нашем случае число степеней свободы равно (2- 1)*(2- 1)= 1.

Табличное значение χ2 (см. табл. в Приложении) для уровня значимости 0,05 и 1 степени свободы составляет 3,84. Поскольку вычисленное нами значение х2 намного больше, нулевую гипотезу можно считать опровергнутой. Значит, между употреблением наркотика и глазодвигательной координацией действительно существует связь. Следует, однако, отметить, что если число степеней свободы больше 1, то критерий х2 нельзя применять, когда в 20 или более процентах случаев теоретические частоты меньше 5 или когда хотя бы в одном случае теоретическая частота равна 0 (Siegel, 1956).

Критерий знаков — это еще один непараметрический метод, позволяющий легко проверить, повлияла ли независимая переменная на выполнение задания испытуемыми, при этом методе сначала подсчитывают число испытуемых, у которых результаты снизились, а затем сравнивают его с тем числом, которого можно было ожидать на основе чистой случайности (в нашем случае вероятность случайного события 1:2). Далее определяют разницу между этими двумя числами, чтобы выяснить, насколько она достоверна.

При подсчетах результаты, свидетельствующие о повышении эффективности, берут со знаком плюс, а о снижении — со знаком минус; случаи отсутствия разницы не учитывают.

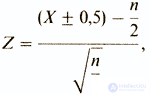

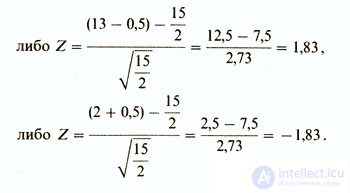

Расчет ведется по следующей формуле:

где Х — сумма «плюсов» или сумма «минусов»;

п /2 — число сдвигов в ту или в другую сторону при чистой случайности один шанс из двух. (Такая вероятность характерна, например, для п бросаний монеты. В случае же если п раз бросают игральную кость, то вероятность выпадения той или иной грани уже равна одному шансу из 6 ( п /6))

0,5 — поправочный коэффициент, который добавляют к X, если X<п /2, или вычитают, если X>п /2.

Если мы сравним в нашем опыте результативность испытуемых до воздействия (фон) и после воздействия, то получим

Опытная группа

| Фон: | 12 | 21 | ten | 15 | 15 | nineteen | 17 | 14 | 13 | eleven | 20 | 15 | 15 | 14 | 17 |

| После воздействия: | eight | 20 | 6 | eight | 17 | ten | ten | 9 | 7 | eight | 14 | 13 | sixteen | eleven | 12 |

| Знак: | - | - | - | - | + | - | - | - | - | - | - | - | + | - | - |

Итак, в 13 случаях результаты ухудшились, а в 2 — улучшились. Теперь нам остается вычислить Z для одного из этих двух значений X:

Из таблицы значений Z можно узнать, что Z для уровня значимости 0,05 составляет 1,64. Поскольку полученная нами величина Z оказалась выше табличной, нулевую гипотезу следует отвергнуть; значит, под действием независимой переменной глазодвигательная координация действительно ухудшилась.

Критерий знаков особенно часто используют при анализе данных, получаемых в исследованиях по парапсихологии. С помощью этого критерия легко можно сравнить, например, число так называемых телепатических или психокинетических реакций (X) с числом сходных реакций, которое могло быть обусловлено чистой случайностью ( п /2).

Существуют и другие непараметрические критерии, позволяющие проверять гипотезы с минимальным количеством расчетов.

Критерий рангов позволяет проверить, является ли порядок следования каких-либо событий или результатов случайным, или же он связан с действием какого-то фактора, не учтенного исследователем. С помощью этого критерия можно, например, определить, случаен ли порядок чередования мужчин и женщин в очереди. В нашем опыте этот критерий позволил бы узнать, не чередуются ли плохие и хорошие результаты каждого испытуемого опытной группы после воздействия каким-то определенным образом или не приходятся ли хорошие результаты в основном на начало или конец испытаний.

При работе с этим критерием сначала выделяют такие последовательности, в которых подряд следуют значения меньше медианы, и такие, в которых подряд идут значения больше медианы. Далее по таблице распределения R (от англ, runs- последовательности) проверяют, обусловлены ли эти различные последовательности только случайностью.

При работе с порядковыми данными используют такие непараметрические тесты, как тест U (Манна-Уитни) и тест Т Вилкоксона . Тест U позволяет проверить, существует ли достоверная разница между двумя независимыми выборками после того, как сгруппированные данные этих выборок классифицируются и ранжируются и вычисляется сумма рангов для каждой выборки. Что же касается критерия Т, то он используется для зависимых выборок и основан как на ранжировании, так и на знаке различий между каждой парой данных.Такие данные чаще всего получаются при ранжировании количественных данных, которые нельзя обработать с помощью параметрических тестов.

Чтобы показать применение этих критериев на примерах, потребовалось бы слишком много места. При желании читатель может подробнее ознакомиться с ними по специальным пособиям.

При изучении корреляций стараются установить, существует ли какая-то связь между двумя показателями в одной выборке (например, между ростом и весом детей или между уровнем IQ и школьной успеваемостью) либо между двумя различными выборками (например, при сравнении пар близнецов), и если эта связь существует, то сопровождается ли увеличение одного показателя возрастанием (положительная корреляция) или уменьшением (отрицательная корреляция) другого.

Иными словами, корреляционный анализ помогает установить, можно ли предсказывать возможные значения одного показателя, зная величину другого.

До сих пор при анализе результатов нашего опыта по изучению действия марихуаны мы сознательно игнорировали такой показатель, как время реакции. Между тем было бы интересно проверить, существует ли связь между эффективностью реакций и их быстротой. Это позволило бы, например, утверждать, что чем человек медлительнее, тем точнее и эффективнее будут его действия и наоборот.

С этой целью можно использовать два разных способа: параметрический метод расчета коэффициента Браве-Пирсона (r) и вычисление коэффициента корреляции рангов Спирмена (rs), который применяется к порядковым данным, т.е. является непараметрическим. Однако разберемся сначала в том, что такое коэффициент корреляции.

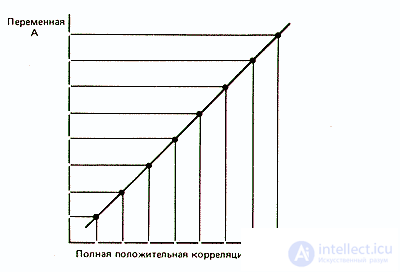

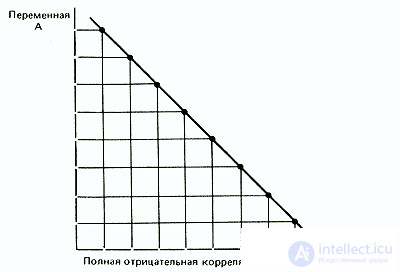

Коэффициент корреляции — это величина, которая может варьировать в пределах от +1 до -1. В случае полной положительной корреляции этот коэффициент равен плюс 1, а при полной отрицательной — минус 1. На графике этому соответствует прямая линия, проходящая через точки пересечения значений каждой пары данных:

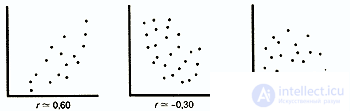

В случае же если эти точки не выстраиваются по прямой линии, а образуют «облако», коэффициент корреляции по абсолютной величине становится меньше единицы и по мере округления этого облака приближается к нулю:

В случае если коэффициент корреляции равен 0, обе переменные полностью независимы друг от друга.

В гуманитарных науках корреляция считается сильной, если ее коэффициент выше 0,60; если же он превышает 0,90, то корреляция считается очень сильной. Однако для того, чтобы можно было делать выводы о связях между переменными, большое значение имеет объем выборки: чем выборка больше, тем достовернее величина полученного коэффициента корреляции. Существуют таблицы с критическими значениями коэффициента корреляции Браве-Пирсона и Спирмена для разного числа степеней свободы (оно равно числу пар за вычетом 2, т. е. n- 2). Лишь в том случае, если коэффициенты корреляции больше этих критических значений, они могут считаться достоверными. Так, для того чтобы коэффициент корреляции 0,70 был достоверным, в анализ должно быть взято не меньше 8 пар данных ( h =n -2=6) при вычислении r (см. табл. 4 в Приложении) и 7 пар данных (h= n-2= 5) при вычислении rs (табл. 5 в Приложении).

Хотелось бы еще раз подчеркнуть, что сущность этих двух коэффициентов несколько различна. Отрицательный коэффициент r указывает на то, что эффективность чаще всего тем выше, чем время реакции меньше, тогда как при вычислении коэффициента rs требовалось проверить, всегда ли более быстрые испытуемые реагируют более точно, а более медленные — менее точно.

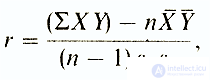

Коэффициент корреляции Браве-Пирсона (r) — этопараметрический показатель, для вычисления которого сравнивают средние и стандартные отклонения результатов двух измерений. При этом используют формулу (у разных авторов она может выглядеть по-разному)

где Σ XY — сумма произведений данных из каждой пары;

n-число пар;

X — средняя для данных переменной X;

Y — средняя для данных переменной Y

Sx — стандартное отклонение для распределения х;

Sy — стандартное отклонение для распределения у

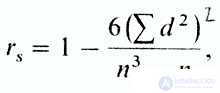

Коэффициент корреляции рангов Спирмена ( rs ) — это непараметрический показатель, с помощью которого пытаются выявить связь между рангами соответственных величин в двух рядах измерений.

Этот коэффициент рассчитывать проще, однако результаты получаются менее точными, чем при использовании r. Это связано с тем, что при вычислении коэффициента Спирмена используют порядок следования данных, а не их количественные характеристики и интервалы между классами.

Дело в том, что при использовании коэффициента корреляции рангов Спирмена (rs) проверяют только, будет ли ранжирование данных для какой-либо выборки таким же, как и в ряду других данных для этой выборки, попарно связанных с первыми (например, будут ли одинаково «ранжироваться» студенты при прохождении ими как психологии, так и математики, или даже при двух разных преподавателях психологии?). Если коэффициент близок к +1, то это означает, что оба ряда практически совпадают, а если этот коэффициент близок к -1, можно говорить о полной обратной зависимости.

Коэффициент rs вычисляют по формуле

где d — разность между рангами сопряженных значений признаков (независимо от ее знака), а — число пар.

Обычно этот непараметрический тест используется в тех случаях, когда нужно сделать какие-то выводы не столько об интервалах между данными, сколько об их рангах, а также тогда, когда кривые распределения слишком асимметричны и не позволяют использовать такие параметрические критерии, как коэффициент r (в этих случаях бывает необходимо превратить количественные данные в порядковые).

Summary

Итак, мы рассмотрели различные параметрические и непараметрические статистические методы, используемые в психологии. Наш обзор был весьма поверхностным, и главная задача его заключалась в том, чтобы читатель понял, что статистика не так страшна, как кажется, и требует в основном здравого смысла. Напоминаем, что данные «опыта», с которыми мы здесь имели дело, — вымышленные и не могут служить основанием для каких-либо выводов. Впрочем, подобный эксперимент стоило бы действительно провести. Поскольку для этого опыта была выбрана сугубо классическая методика, такой же статистический анализ можно было бы использовать во множестве различных экспериментов. В любом случае нам кажется, что мы наметили какие-то главные направления, которые могут оказаться полезны тем, кто не знает, с чего начать статистический анализ полученных результатов.

Literature

Приложение. Таблицы

Примечания. 1) Для больших выборок или уровня значимости меньше 0,05 следует обратиться к таблицам в пособиях по статистике.

2) Таблицы значений других непараметрических критериев можно найти в специальных руководствах (см. библиографию).

| Таблица 1. Значения критерия t Стьюдента | |

| h | 0.05 |

| one | 6,31 |

| 2 | 2,92 |

| 3 | 2.35 |

| four | 2,13 |

| five | 2,02 |

| 6 | 1.94 |

| 7 | 1.90 |

| eight | 1.86 |

| 9 | 1.83 |

| ten | 1.81 |

| eleven | 1,80 |

| 12 | 1.78 |

| 13 | 1,77 |

| 14 | 1.76 |

| 15 | 1,75 |

| sixteen | 1,75 |

| 17 | 1,74 |

| 18 | 1.73 |

| nineteen | 1.73 |

| 20 | 1.73 |

| 21 | 1.72 |

| 22 | 1.72 |

| 23 | 1.71 |

| 24 | 1.71 |

| 25 | 1.71 |

| 26 | 1.71 |

| 27 | 1.70 |

| 28 | 1.70 |

| 29 | 1.70 |

| thirty | 1.70 |

| 40 | 1.68 |

| ¥ | 1.65 |

| Table 2. The values of the criterion χ2 | |

| h | 0.05 |

| one | 3.84 |

| 2 | 5.99 |

| 3 | 7.81 |

| four | 9.49 |

| five | 11.1 |

| 6 | 12.6 |

| 7 | 14.1 |

| eight | 15.5 |

| 9 | 16.9 |

| ten | 18.3 |

| Table 3. Valid Z Values | |

| R | Z |

| 0.05 | 1.64 |

| 0.01 | 2.33 |

продолжение следует...

Часть 1 Statistics and data processing in psychology

Часть 2 Levels of confidence (significance) - Statistics and data processing in

Часть 3 - Statistics and data processing in psychology

Comments

To leave a comment

Mathematical Methods in Psychology

Terms: Mathematical Methods in Psychology